Actueel

Wat mag (niet) met AI op school?

Mag je examens verbeteren met AI? Moet je altijd melden dat je een AI-tool gebruikt? Expert Vincent Vanrusselt (PXL) beantwoordt 13 brandende vragen vanuit de wetgeving rond AI in onderwijs en gezond verstand.

VRAAG 1

Mag ik AI-gegenereerde afbeeldingen of teksten gebruiken in mijn lesmateriaal?

Vincent Vanrusselt, onderzoekshoofd PXL Centrum Digitaal Leren: “Sinds 1 augustus 2024 is de Europese AI Act van kracht, ook in onderwijs. Onze sector staat vaak ingedeeld als ‘hoog risico’ (zie kader). Generatieve AI valt onder ‘laag risico’. Dus voorlopig mag je met een gerust hart een afbeelding of tekst genereren met een AI-tool zoals ChatGPT, Copilot, Gemini, Perplexity of Claude.”

“Wie de prompt maakt, geldt als een soort eigenaar. De gegenereerde content is niet echt van jou, maar is rechtenvrij. De aanbieder – Open AI, Microsoft, Meta – heeft dus in principe geen rechten op jouw afbeelding of tekst. Maar je leest het best goed de gebruikersvoorwaarden. En dan nog is het niet altijd duidelijk of de soms vage omschrijvingen wettelijk zijn.”

“Weet wel dat andere mensen je AI-content ook mogen gebruiken. Dus als je een publiciteitscampagne voor je school maakt, mag in theorie een andere school die afbeeldingen ook gebruiken.”

“Uiteraard leven hier nog veel ethische vragen rond. Want die grote taalmodellen zijn getraind met datasets vol afbeeldingen en teksten van artiesten en auteurs. Sommige mediabedrijven en kunstenaars hebben al juridische stappen gezet. In de toekomst gaan ChatGPT en consoorten misschien auteurs moeten vergoeden, hogere tarieven doorrekenen aan de gebruiker, minder trainingsdata hebben en minder goede output afleveren. Maar dat is nog koffiedik kijken.”

VRAAG 2

Mag ik controleren of een tekst met of zonder AI is geschreven?

Vincent Vanrusselt: “Er bestaan heel wat tools om te checken of een tekst door artificiële intelligentie of door een mens is geschreven. Maar het is moeilijk tot onmogelijk om dat met 100% zekerheid te controleren. Net zoals je niet kan bewijzen of een opdracht door een ouder is gemaakt.”

“Transparantie werkt beter in de praktijk. Leer je leerlingen met AI-tools werken. Bereid ze voor op een werkvloer waar collega’s volop AI-tools gebruiken. Voor bepaalde opdrachten of competenties mogen leerlingen uitdrukkelijk geen AI-tool gebruiken. Weet je zeker dat ze dat toch deden, kan je daar wel punten voor aftrekken.”

VRAAG 3

Mag ik taken of examens verbeteren met AI?

Vincent Vanrusselt: “Uit een intern onderzoek van PXL blijkt dat een AI-model objectiever en nauwkeuriger toetsen, examens of een stageverslag verbetert dan een leraar. Op voorwaarde dat je een goede rubric meegeeft waarbij je alle criteria en beheersingsniveaus gedetailleerd beschrijft. Laat je leerlingen ook weten dat een AI-tool je ondersteunt.”

“Uiteraard kijk je de output zelf nog na. De AI Act klasseert automatisch verbeteren en scoren als hoog risico. Een mens moet de uiteindelijke beslissing nemen, anders zou een machine de toekomst van kinderen bepalen. Besef ook dat je het AI-model voedt met data van leerlingen, anonimiseer die dus altijd.”

VRAAG 4

Mag ik minderjarige leerlingen een account laten aanmaken op een AI-tool?

Vincent Vanrusselt: “Open AI adviseert om kinderen pas vanaf 13 jaar met ChatGPT te laten werken. Dat is natuurlijk geen wetgeving, maar een richtlijn van een groot technologiebedrijf. De adviesleeftijd van Unesco is 12 jaar. Thuis omzeilen leerlingen dat vlotjes door een andere geboortedatum in te vullen, maar op school hou je het best rekening met die leeftijdsgrens. Het is niet verplicht, maar wel aangewezen om toestemming aan ouders te vragen of hun kind generatieve AI-tools mag gebruiken.”

“Onze maatschappij voelt die grens zelf ook aan. In de lagere school, 1e en 2e graad secundair is er een smartphoneverbod aangekondigd. En zelfs in de 3e graad secundair is er een groeiende weerstand tegen te veel schermen op school, te veel online spel, cyberpesten en gebruik van data van leerlingen.”

“In de toekomst zijn bedrijven dankzij de AI Act verplicht om te melden of een digitale toepassing op de achtergrond artificiële intelligentie gebruikt. Dat zal er uitzien zoals je nu al dan niet instemt met cookies op een website.”

VRAAG 5

Moet ik het gebruik van AI-tools altijd vermelden?

Vincent Vanrusselt: “Als leraar ben je het best transparant over het gebruik van AI. Maar wanneer en hoe, dat verandert. Als je een mail naar ouders of leerlingen herschrijft met Copilot, moet je dat niet per se vermelden. Maak je een toets of lesmateriaal met behulp van generatieve AI, kan je dat vermelden, maar het is zeker niet wettelijk verplicht.”

“APA-stijl werkte een bronvermelding uit voor artificiële intelligentie waarbij je de auteur van het model, het jaartal, het type en de website vermeldt.”

“Een gedragen kader is cruciaal om alle leerlingen en leraren duidelijkheid te bieden. Anders doet de leraar geschiedenis het zus en collega Frans het zo. Bij een gebrek aan of vage afspraken durven leerlingen en leraren artificiële intelligentie niet gebruiken uit schrik iets tegen de regels te doen.”

VRAAG 6

Wat als leerlingen weigeren om AI-tools te gebruiken?

Vincent Vanrusselt: “In Nederland willen sommige studenten in hoger onderwijs geen AI-tools gebruiken om ethische of ecologische redenen. Wil je die leerlingen tegemoet komen? Dan kunnen ze in een proces kiezen of ze AI-tools gebruiken en in de uiteindelijke beoordeling moet iedereen het zonder doen. Natuurlijk is het een goed idee om met je leerlingen stil te staan bij het energieverbruik en ethische kwesties bij AI.”

VRAAG 7

Mag ik cursusmateriaal van een uitgeverij uploaden in een AI-tool?

Vincent Vanrusselt: “Je kan als leraar heel gemakkelijk een cursus uploaden in een AI-model om bijvoorbeeld toetsvragen of oefeningen te genereren. Maar wees je er wel bewust van dat gratis tools alle input gebruiken om het systeem verder te trainen en beter te maken. Gebruik liefst een tool die je data niet terug in het systeem stuurt. Maar zelfs als een – vaak betalende – tool beweert dat niet te doen, ben je nooit helemaal zeker.”

VRAAG 8

Mag een school een AI-chatbot gebruiken in communicatie met leerlingen of ouders?

Vincent Vanrusselt: “Je kan als school een chatbot maken om bijvoorbeeld leerlingen en ouders te helpen bij vragen over het schoolreglement, studierichtingen of wat meenemen op de sportdag. Vertel gebruikers dat ze met een chatbot communiceren en verwittig dat ze beter geen persoonlijke info meegeven. Zelfs al lijkt een chatbot een afgeschermde omgeving, op de achtergrond draait natuurlijk altijd een AI-model.”

“Het is nog onduidelijk of scholen voor de AI Act altijd ‘gebruikersverantwoordelijken’ of uitzonderlijk ook plots ‘aanbieder’ zijn als je bijvoorbeeld je eigen chatbot bouwt en die aanbiedt aan ouders of leerlingen. In dat geval moeten scholen extra maatregelen nemen om een AI-systeem veilig en ethisch te gebruiken.”

“De pedagogische of technische ICT-coördinator kent het best de basis zodat die collega’s kan adviseren. Voor meer gespecialiseerde kennis kan je leunen op je schoolgemeenschap of onderwijskoepel die met een jurist of data processing officer (DPO) de meest recente wetgeving rond AI in onderwijs vertaalt naar een schoolreglement en directeurs.”

VRAAG 9

Is het oké om AI te gebruiken voor een Facebook-post over de school?

Vincent Vanrusselt: “Er zijn heel wat handige tools om socialemediaberichten en -afbeeldingen te genereren. Je kiest zelf of je meldt dat je daarvoor artificiële intelligentie gebruikt. Alleen als je een deepfake (realistische nepvideo’s gemaakt met AI) publiceert, moet je dat vermelden volgens het laagste risiconiveau van de AI Act.”

VRAAG 10

Mag ik adaptieve leermiddelen met artificiële intelligentie gebruiken?

Vincent Vanrusselt: “AI-systemen die leerresultaten evalueren en het leerproces sturen, vallen onder hoog risico in de AI Act. Adaptieve leermiddelen zoals Snappet of Bingel gebruiken is geen probleem. Maar die adaptieve toets gebruiken om leerlingen automatisch toe te laten of uit te sluiten in een bepaalde studierichting mag niet.”

VRAAG 11

Hoe weet ik of een tool in orde is met de wetgeving rond AI in onderwijs?

Vincent Vanrusselt: “Het is niet evident om bij elke tool uit te zoeken of die correct omgaat met data. Altijd een goed idee om dit te checken bij je pedagogische of technische ICT-coördinator. Het Centrum Digitaal Leren van PXL lijst ook heel wat betrouwbare tools op in brAIntool.”

“De AI Act is verbonden met en bouwt verder op de GDPR-regelgeving. Als leraar kan het natuurlijk geen kwaad om mee te zijn. Zo weten we ondertussen allemaal dat we volgens de GDPR-regelgeving toestemming moeten vragen voor de publicatie van foto’s van leerlingen. Die kennis gaan we over wetgeving rond AI in onderwijs ook opbouwen de komende jaren.”

VRAAG 12

Riskeer ik als leraar of school een sanctie?

Vincent Vanrusselt: “Leraren en scholen gebruiken vooral generatieve AI, een aparte categorie in de AI Act. Geen enkele generatieve AI-tool zit in een hoger risicoprofiel. Maar de concretisering en handhaving vragen nog verfijning. Sancties gaan in ieder geval altijd naar de toolbouwer en nooit naar de gebruiker. De Europese AI Act dient net om de gebruikers te beschermen en de producenten te responsabiliseren.”

VRAAG 13

Moet een school een risicoanalyse maken?

Vincent Vanrusselt: “Volgens de AI Act moeten bedrijven in bepaalde situaties een risicoanalyse maken. Dat is verplicht voor scholen bij hoog risico-activiteiten (zie kader). Maar het is sowieso verstandig om dit mee te nemen in ICT-beleidsplannen.”

“Denk bij een beleidsplan verder dan artificiële intelligentie. Weet je welke tools je team gebruikt? Weet je of die tools voldoen aan de GDPR-wetgeving en de AI Act? Wat gebeurt er met data van je leerlingen? Zijn je gegevens veilig afgeschermd? Gebruikt iedereen een tweestapsverificatie? Zijn er nog onveilige USB-sticks in omloop? Door de komst van AI kijken we ook weer aandachtiger naar cybersecurity en GDPR.”

AI Act in onderwijs

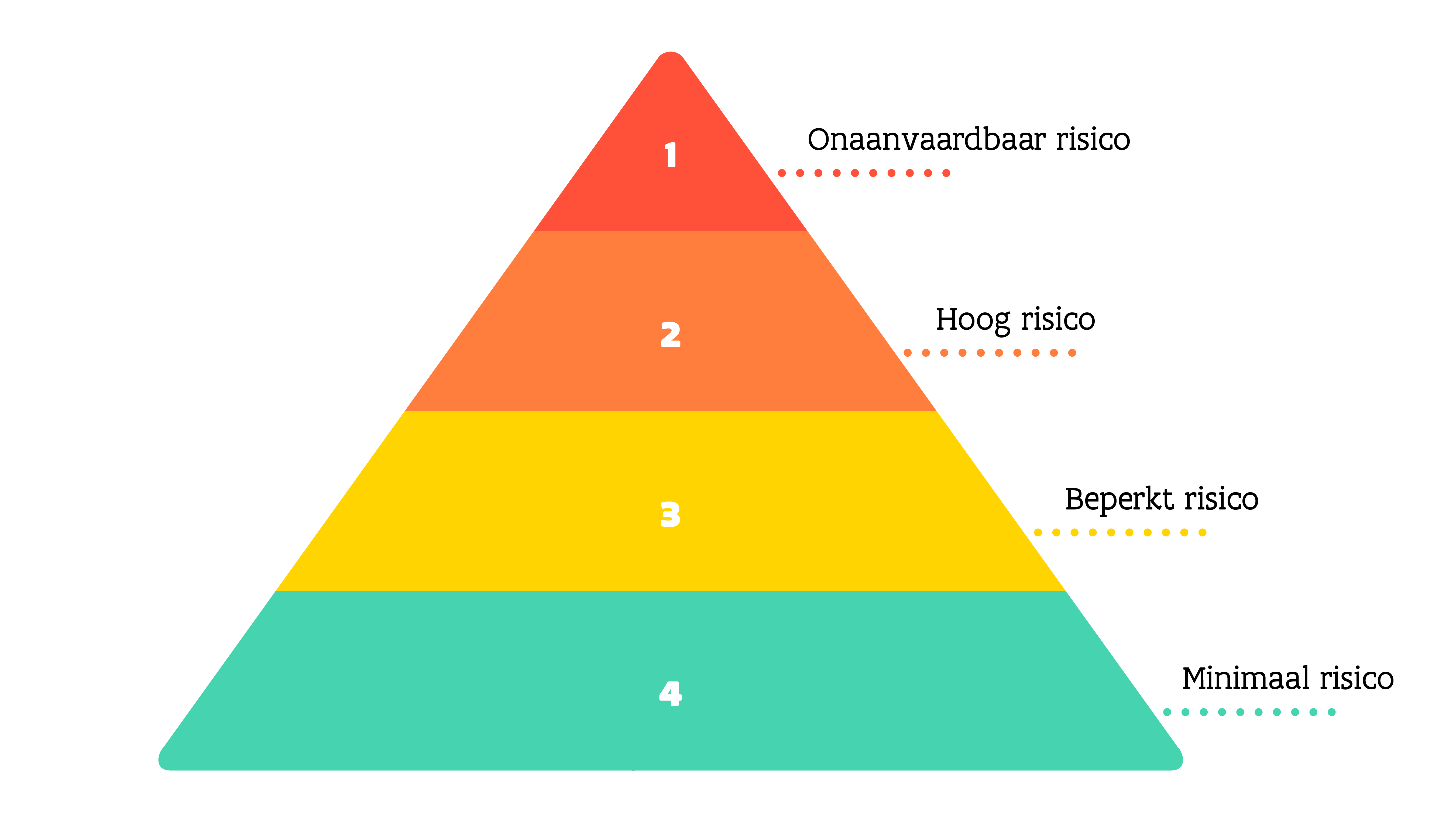

De AI Act is de eerste Europese wet die artificiële intelligentie reguleert. Dit juridische kader zorgt voor veilige en betrouwbare AI-systemen en beschermt de grondrechten van EU-burgers. De regels gelden voor iedereen die AI ontwikkelt of aanbiedt. Het kader deelt AI in volgens 4 risiconiveaus:

- Onaanvaardbaar risico: sommige toepassingen zoals emotieherkenning bij leerlingen zijn verboden.

- Hoog risico: in kritieke sectoren zoals onderwijs gelden strenge eisen voor AI als er een grote impact is op de onderwijs- en loopbaanmogelijkheden van een leerling.

- Toegang, toelating en toewijzing tot onderwijs: bijvoorbeeld een AI-systeem dat inschrijvingen beoordeelt en bepaalt of een leerling wordt toegelaten tot een school.

- Evalueren van leerresultaten en sturen van het leerproces: bijvoorbeeld AI die zelfstandig een werkstuk van een leerling leest en cijfers toekent. Of adaptieve leersystemen waarbij de leerstof automatisch wordt aangepast aan het niveau van de leerling.

- Beoordelen van het passend onderwijsniveau: bijvoorbeeld AI die leerlingen schooladvies voor een secundaire school geeft.

- Monitoren en detecteren van ongeoorloofd gedrag tijdens toetsen: bijvoorbeeld antispieksoftware.

- Beperkt risico: bij chatbots of AI-gegenereerde content moet je transparant zijn en laten weten dat je met een chatbot of deepfake te maken hebt.

- Minimaal risico: bij spamfilters of AI in games zijn geen verplichtingen.

De wet wordt geleidelijk ingevoerd. De meeste bepalingen, zoals die voor hoog risico-AI-systemen, zullen pas 2 jaar na de inwerkingtreding (1 augustus 2024) gelden. Dit geeft ontwikkelaars en gebruikers de tijd om rekening te houden met de richtlijnen.

Klasse en Digisprong proberen de snel veranderende wetgeving rond AI in onderwijs in dit artikel up-to-date te houden.

Log in om te bewaren

Laat een reactie achter